El aumento de la latencia y la inestabilidad tienen un efecto adverso en el rendimiento de la red, por lo que es esencial monitorearlo periódicamente. Este aumento en la latencia y la fluctuación de fase se produce cuando la velocidad de los dos dispositivos no coincide; la congestión hace que los búferes se desborden, las ráfagas de tráfico.

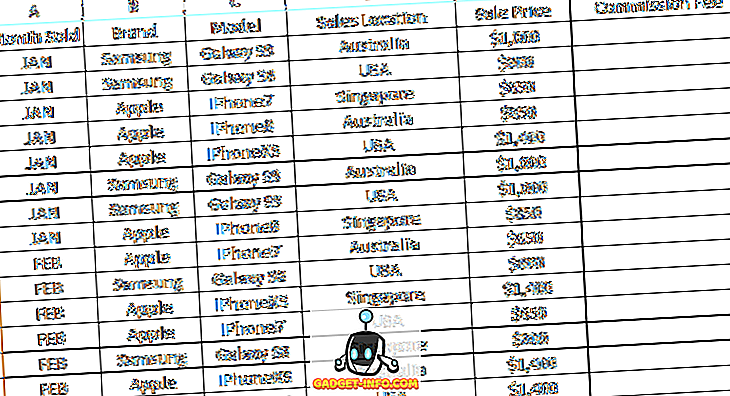

Gráfica comparativa

| Bases para la comparación | Estar nervioso | Estado latente |

|---|---|---|

| BASIC | Diferencia en la demora entre los dos paquetes consecutivos. | Retraso a través de la red. |

| Causas | Congestión en la red. | Demora de propagación, serialización, protocolos de datos, conmutación, enrutamiento, almacenamiento en búfer de paquetes. |

| Prevención | Usando una marca de tiempo. | Múltiples conexiones a internet. |

Definición de Jitter

La fluctuación de fase es la diferencia entre los retrasos de los paquetes IP. En otras palabras, cuando la demora de la latencia de la variable a través de la red provoca fluctuaciones. Se puede explicar con un ejemplo, suponiendo que se envíen cuatro paquetes en los momentos 0, 1, 2, 3 y recibidos a los 10, 11, 12, 13, el retraso entre los paquetes es el mismo en todos los paquetes, que es de 10 unidades de tiempo. En el caso diferente, si estos paquetes llegan a 11, 13, 11 y 18, entonces el retardo generado es 11, 12, 9, 15, que será diferente del caso anterior.

La primera forma de demora no afectaría las aplicaciones como el audio y el video, porque todos los paquetes tienen la misma demora. Sin embargo, en el segundo caso, el retraso diferente para el paquete no es aceptable, y también resulta en la llegada de los paquetes fuera de orden. El jitter alto significa que la diferencia entre los retrasos es masiva, mientras que el jitter bajo significa que la variación es pequeña.

Definición de latencia

La latencia es el tiempo requerido por un paquete de datos para llegar al destino desde la fuente. En términos de redes, el tiempo transcurrido entre el procesamiento de la solicitud para acceder a la red generada por el usuario y obtener una respuesta de la solicitud al usuario. En términos generales, la latencia es el tiempo transcurrido entre la ejecución de los dos eventos.

La latencia es simplemente el tiempo requerido para procesar los mensajes en los extremos de origen y destino y los retrasos generados en la red. Hay dos formas en que se puede medir la latencia de la red, la primera se llama latencia unidireccional en la que solo se mide el tiempo transcurrido en la fuente que envía el paquete y el destino que lo recibe. Mientras que en el otro tipo, la latencia unidireccional del nodo A al nodo B se resume con la latencia unidireccional del nodo B al nodo A y se conoce como ida y vuelta.

Diferencias clave entre jitter y latencia

- El retraso producido en la salida y llegada del paquete IP desde el origen al destino se conoce como latencia. A la inversa, fluctúa la variación en el retardo producido por la transmisión de paquetes.

- La congestión en la red puede causar fluctuaciones mientras que la latencia se puede producir a través del retardo de propagación, la conmutación, el enrutamiento y el almacenamiento en búfer.

- El jitter se puede evitar mediante el uso de marcas de tiempo. Por el contrario, la latencia puede reducirse mediante el uso de múltiples conexiones a Internet.

Conclusión

La fluctuación de fase y la latencia son las métricas cruciales para supervisar y medir el rendimiento de la red. La latencia es el período que comienza desde la transmisión del paquete desde el remitente hasta la recepción del paquete en el receptor. Por otro lado, el jitter es la diferencia entre el retardo de reenvío de los dos paquetes recibidos consecutivos en los mismos flujos.